探秘NVIDIA HGX B200集群,超多图:深度解析NVIDIA最新超级计算平台

公众号记得加星标⭐️,第一时间看推送不会错过。

来 源:内容编译自servethehome 。

几周前,我们(指代servethehome作者,下同)有幸参观了俄亥俄州首批采用风冷技术的 NVIDIA HGX B200 集群之一。该集群由 Supermicro 服务器组成,用于 Lambda 的一键式 AI 集群,并部署在 Cologix 公司。该集群耗资数亿美元,并且使用了全新的 GPU,因此参观体验非常震撼。

在本文中,我们将深入探讨从未参观过此类集群的人们可能从未体验过的细节。

我们无法透露安装的 NVIDIA B200 GPU 的具体数量,但可以肯定的是,数量达数千颗。想想就在几年前,如此规模的系统还能算得上是顶级超级计算机,真是不可思议。如今,它已成为一个令人瞩目的 AI 集群。

集群本身采用风冷设计,从而加快了集群部署速度。对于像 Lambda 这样的公司来说,快速上线 GPU 意味着他们可以将这些 GPU 转变为随时可供客户租用的在线集群。

每个 Supermicro NVIDIA HGX B200 平台上的机架均装有 32 个 GPU,每个机架上装有 4 个 GPU,这些 GPU 排列成排,并设有冷通道和热通道。GPU 产生的热量被控制并循环到建筑物外部。

您会注意到,GPU 排列在八个 GPU 服务器机架的排成一排,每个机架配备四台服务器。每台服务器配备八个 GPU。这意味着,如下所示的排总共有 256 个 GPU。

在本文的后续部分,我们将详细介绍这些机架。从服务器到网络、存储,甚至一些经常被忽视的部分。

我们还将进入数据中心级冷却系统,以使该集群保持凉爽。

这个集群并非Cologix 36MW设施中唯一的集群,所以我们还会带您参观一下发电场的外部。我在照片里可能看起来很小,但它比照片里看起来还要大。

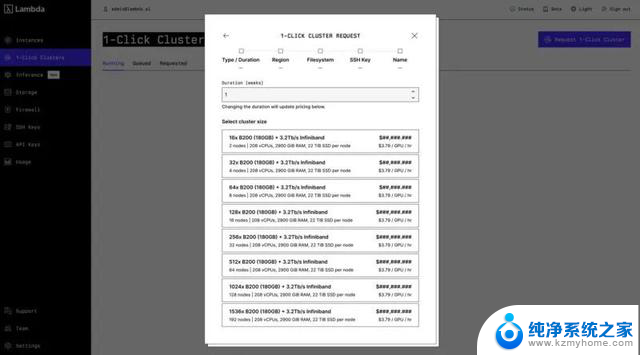

这样做的真正原因是为了支持 Lambda 的一键式集群。对于许多云提供商来说,如果您需要 GPU 集群,则需要联系销售人员,然后进行配置流程,这需要时间和耐心。Lambda 的一键式集群则是另一种选择。您可以使用信用卡进行配置,而无需经过手动销售流程。这就是 Lambda Neo-Cloud 的体验。

虽然我们展示了风冷式 NVIDIA HGX B200,但值得注意的是。我们派了一个团队去另一个工厂检查了 Lambda 的液冷式 Supermicro NVIDIA GB200 NVL72 机架之一。您可以在随附的视频中看到。

我认为值得注意的是,参与我们正在关注的主要集群的公司,Supermicro、Lambda、Cologix 和 NVIDIA,并非仅仅构建一个集群。相反,这更像是一种寻找可用电力和数据中心空间,然后在这些可用位置构建集群的实践。

好了,让我们来了解一下这类集群的组件,包括 GPU 服务器、网络、存储、CPU 计算以及设施的电源和冷却系统。让我们开始吧。

NVIDIA HGX B200 10U 风冷服务器

如图所示,机箱顶部用于安装巨大的 NVIDIA HGX B200 8 GPU 底板。由于本机箱中的 B200 GPU 采用风冷设计,因此大部分垂直高度都由 B200 散热器占据。为了让您了解原因,我协助您安装了一块 B200。

这是一个很好的角度,您可以看到底部的 B200 的 SXM 封装,然后可以看到 GPU 顶部的散热器有多大。

在这里,我通过手持手机闪光灯来提供“增值”。将扭矩起子穿过散热器并插入螺丝并不容易。

在我们进入正题之前,先简单说一下,这很好地解释了为什么在 GPU 服务器中,主板最好位于 8 GPU 基板下方。随着新型风冷散热器的出现,散热器会变得更高,以支持更高功率的 GPU。如果主板托盘位于 GPU 基板上方,那么增加散热器高度意味着 GPU 基板和 CPU 主板之间的距离会增加,从而改变 PCIe 链路距离。

GPU 基板下方是系统其他部分所在的地方。其中包括启动 SSD、南北向网卡、前置服务端口、存储设备和风扇。

对于我们的南北网卡,我们使用的是 NVIDIA Bluefield-3 DPU。这几乎已成为 NVIDIA AI 服务器的标配。有时我们会看到两个,但通常只有一个。它可提供 400Gbps 的网络带宽。

除此之外,我们还有两个启动 SSD。

在此之下,在更高端的英特尔型号上,我们有 10 个 2.5 英寸 NVMe 驱动器托架,全部为 PCIe Gen5。

系统底部的一排风扇用于冷却 CPU、DDR5 内存和其他组件。

如果您想在我们的其他集群照片中看到这些,这里是已打开驱动器并连接了 NIC 的前端。

移至系统后部,有许多风扇。

冷却 NVIDIA B200 的顶部是一面巨大的风扇墙,其唯一作用是将空气吸入 NVIDIA HGX B200 底板散热器。

它配备了六个 5250W 电源,可为 HGX B200 8 GPU 基板和 CPU 主板提供正确的电压。每个电源都有两个电源输入。许多竞争系统使用标准的 1U 电源,有时甚至会使用两种不同类型的电源,一些用于 GPU 基板,一些用于主板。更大的双用途电源使其能够保持冗余,同时使用更大的风扇,从而提高效率。电源本身是钛金级的,效率高达 96%,这是一个非常高的水平。

在这种配置中,我们拥有超过 30kW 的电源,可实现 3+3 冗余。

在底部,我们有 NIC 托盘。

板载双 10Gbase-T 网卡,主要用于操作系统和应用程序管理接口。另一个 1GbE 端口用于服务器管理/IPMI 功能。

我们的东西向网络部署了八块 400GbE NVIDIA NDR 网卡。InfiniBand 是该领域的一项知名技术,而 Quantum-2 则是这种规模的高端集群的标志。

如果你想看到它的接线和运行,这里你可以看到冗余的 A+B 电源和 NIC 全部亮起。

NVIDIA B200 集群联网

虽然 GPU 服务器可能备受关注,但网络也同样重要。每个8-GPU 系统内部都配备了 NVLink。为了实现横向扩展,我们需要一个东西向网络,以便跨服务器的 GPU 能够相互通信。我们还需要一个南北向网络,将系统连接到其他基础设施以及集群存储等设备。服务器、数据处理单元 (DPU)、每个机架的配电单元、网络交换机、安全摄像头和设备、环境监视器等都配备了管理网络。网络建设涉及方方面面。

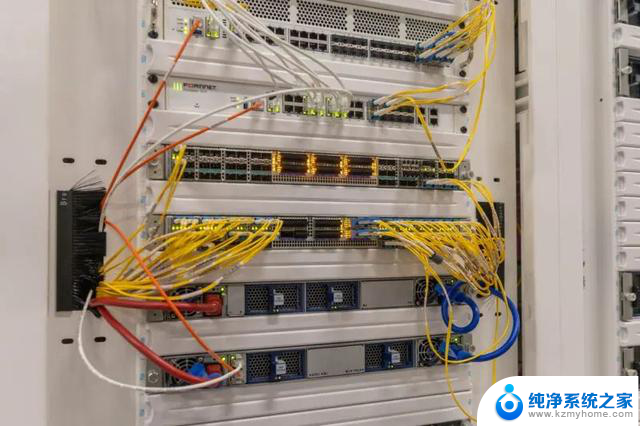

东西向网络的核心是 NVIDIA Quantum-2 网络。此前,我们会将这种 400Gbps 互连称为 NDR InfiniBand。NVIDIA 还有其他精妙的技术,例如 SHARP,可用于集群的网络内计算。不过,就风扇和电源而言,这些 1U 交换机看起来平淡无奇。

光笼方面,它们相当令人兴奋。你可能之前没见过的是,每个 OSFP 光模块都有两个 MPO 接口。

在我们的照片中,您可能还会注意到,不同的网络建立了许多不同类型的连接,从 400Gbps 网络(如 NVIDIA ConnectX-7 和 Quantum-2 东西向网络)一直到管理网络。

部分原因是每个 GPU 都有自己的 ConnectX-7 NIC。

GPU 配备了 8 个 400Gbps 网卡,总容量为 3.2Tbps。此外,每台服务器还配备了 2 个 200Gbps 的 DPU、一个 10GbE 操作系统和应用程序管理端口以及两个管理端口(每台服务器一个 DPU)。Lambda 在这些机器上拥有超过 3.6Tbps 的网络容量,每台 GPU 服务器大约有 13 个网络连接。

网络是我们看到这些每排 256 个 GPU 的主要原因之一。需要注意的是,Lambda 正在将其构建为多租户架构。因此,除了直接切换到设备的网络之外,还有多层网络,以便数千个 GPU 能够进行通信。

与后置 GPU 侧相比,前置 DPU 侧的网络要求相对普通。

以下是一些 Arista Networks 7060DX5-64S 交换机。这些是 64 端口 400GbE 交换机,重要的是它们使用了 QSFP-DD 笼子,使以太网端更加容易。从 NVIDIA Quantum-2 翅片 OSFP 到 NVIDIA ConnectX-7 平顶 OSFP 很容易,但切换到 QSFP-DD 却相当痛苦。我们正在通过一个 1.6-4Tbps 的网络流量生成工具来学习这一点,我们将在未来的网络评测中使用它。

我们参观集群时,有些排还在建设中。你可能会看到这些交换机里空着的笼子,但这其实是好事,因为集群当时还没有完工。以太网端也有很多用途,所以额外的容量在这里是很好的。

我们经常忽略这一点,但仅仅因为我们拥有 200Gbps/400Gbps 网络并不意味着这些是唯一的网络。每台服务器还配备一个 10GbE 操作系统和应用程序管理接口,以及两个 1GbE 管理接口。

这种规模的 AI 集群并非运行 1Gbps 或 10Gbps 光纤链路连接带宽提供商、传统的超大规模云平台等等。相反,这里的上行链路通常以 100Gbps 起步,而且不止一条。客户需要迁移可能存储在云提供商的海量数据,因此集群外部的网络传输至关重要。

尽管我们经常只讨论 GPU 东西网络,但看到有多少种不同类型的网络进入这种类型的集群实际上是相当有趣的。

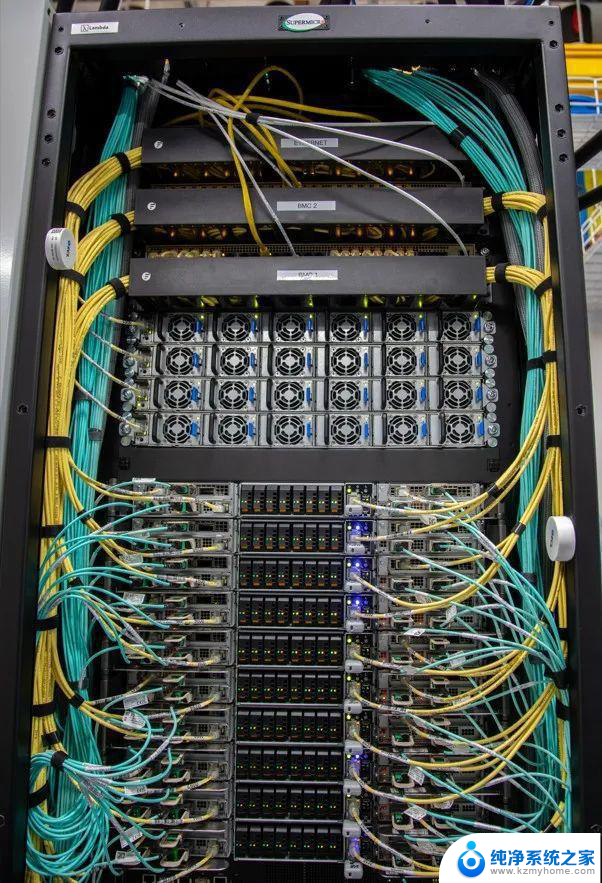

这是集群的两个非 GPU 网络机架的精彩照片。

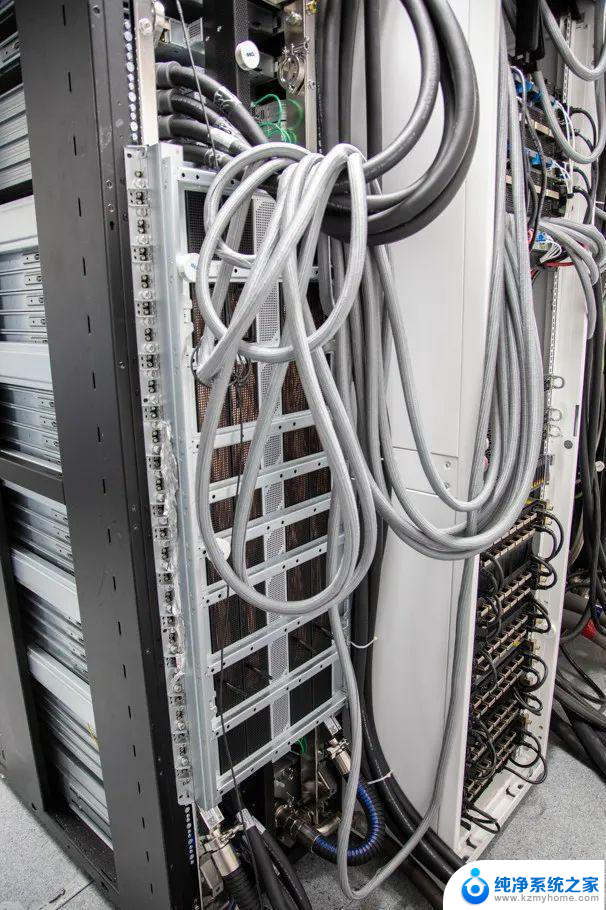

在机架上方,你可能会注意到比洛杉矶高速公路还要多的高架线槽。这些线槽用于承载穿过集群的光纤和网络线缆。

我们经常展示计算机架,但这些是我们如何从单个 GPU 服务器或一个或两个 GPU 服务器机架扩展到数千个 GPU(或更多)。

服务器上的 VAST 存储

GPU 计算固然重要,但为这些 GPU 服务器提供数据也至关重要,因此才会使用 VAST 等高速存储解决方案。VAST Data 的存储在 AI 集群中非常受欢迎。

VAST 以前更像是一家硬件公司,但现在我们更倾向于将其视为一家软件公司。作为其解决方案的一部分,您可以使用不同的服务器。

一键式集群可以快速配置 GPU 集群,而这仅仅是整个流程的一部分。客户还需要将数据从存储位置移动到 GPU 所在的数据中心。此外,客户可能还需要保存输出数据,以备将来的训练和合规性需求。因此,这些阵列通常配备高容量 SSD。

对于那些不经常处理这类问题的人来说,还有一点需要注意。如果你在像 Lambda 这样的设施中拥有 NVIDIA B200 集群,大型知名 AI 公司一旦获得容量,就会寻求租用多年。这样做通常是为了扩大推理操作的规模。在 Lambda 的集群中看到这些阵列不太可能是偶然的,因为那些租用 B200 集群的知名 AI 公司也会有存储偏好。

使用 Cologix 为 AI 集群进行空气冷却

Cologix 在俄亥俄州哥伦布地区及其他地区拥有多个数据中心。它同时拥有液冷和风冷数据中心。我们恰好看到了一个不错的风冷数据中心。

同样,Lambda 拥有多个集群。这只是我们在它运行和扩展期间可以查看的一个集群。

我参观过的大多数数据中心和集群都有一些标志性的东西。对我来说,蓝色的冷却墙将成为这次参观的标志性部分。它们的规模,加上对比鲜明的蓝色,真是赏心悦目。

蓝色网格后面是热交换器。安装在屋顶上的冷却器将液体循环到类似于汽车中大型散热器的装置中。冷通道中较冷的室内空气被吸入超微 GPU 服务器,并通过散热器将组件中的热量散发到空气中。

暖空气随后被困在热通道中,上升并被拉向热交换器。由于噪音大、温度高,我在热通道的行程很短。

这些热交换器将空气中的热量带走,并传递到流体回路。热量带走后,空气再循环到数据中心的冷通道中。

数据中心的空气交换方式有很多种。从技术上讲,有一个液体循环将热量从集群中带出并排出。在业内,我们不把这种液体冷却称为“AI集群”。相反,这被称为空气冷却,因为我们的热量从GPU/CPU通过散热器进入空气,然后进入数据中心的液体循环。

我们使用液体冷却,就像我们在 Lambda 的 Supermicro GB200 NVL72 机架上看到的那样,来描述从 GPU/CPU 到液体冷却块。

散热固然有趣,但你可能想知道功率。接下来,我们来聊聊功率。

Cologix 数据中心拥有自己的变电站。

虽然这不是 AI 集群之旅的一部分,但有些人从未见过它的样子。

出于安全考虑,我们没有参观围栏区域。这是一个36兆瓦的发电厂。

为了直观地了解一下规模,这里是设施外一排装有电池组的电源箱。每个电源箱的额定功率约为1.6兆瓦。如果你眯起眼睛,或许能看到我正穿过数据中心和这些单元之间的走廊。

电力随后被输送到设施内部,并通过母线/母线槽进行分配。我们去年在另一个视频中讲解过母线/母线槽。

使用这种设置的优点是,可以使用分线盒通过可移动的高架箱将正确类型的电源输送到机架。

您可以看到这样的例子:不同的机架使用不同的分接盒,具体取决于所配置的机架类型。

这看起来像是一个小功能,但如果将来发生升级并且机架移动或需要不同类型的电源,这些分接箱需要几分钟才能交换和移动。

人工智能集群中被遗忘的部分

当你看到这张图片时,你可能会被 GPU 服务器、网络交换机、防火墙、冷通道封闭系统或架空电缆槽所吸引。如果你仔细观察,你可能会发现一些 AI 集群中被遗忘的部分。

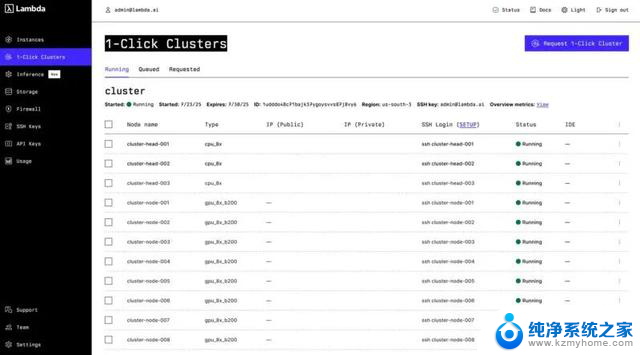

在机架的中间,还有传统的计算服务器。这里有三台1U 服务器。

我们还在集群周围发现了许多 2U 服务器。

我们讨论了一些其他的 1U 存储服务器,但我们看到如此多的传统 CPU 计算平台是有原因的。Lambda 需要运营其集群。客户需要与 AI 服务器一起部署的传统计算资源来协调活动并提供其他服务。我们不会提供确切的数量,但如果您观看视频并查找,您会注意到在 GPU 服务器旁边有许多不同规格的传统计算节点。

这是正在运行的集群的快速屏幕截图,您可以看到正在运行的 GPU 节点,以及基于 CPU 的节点。

还有许多其他组件。例如,你可能注意到了红色和蓝色的电源线、PDU、不同类型的标签(Sharpie 版的可能是最有趣的)、线缆管理设备等等。看到这么多东西必须组合在一起才能使集群正常工作,总是很有趣的。

虽然投资者可能会关注服务器、NVIDIA GPU、存储供应商、网络交换机、光学模块等高价产品,但这只是此类集群整体 BOM 的一部分。

相反,如果缺少这些其他部分,集群通常无法上线,昂贵的 GPU 服务器就会闲置,无法为客户工作负载提供服务。

更重要的是,即使看似很小的细节也会对供应链产生影响,例如交换机上的气流方向。

细微之处也可能造成影响。例如,如果您定制了光纤束,但长度不合适,则需要重新布线,从而导致上线延迟。人工智能集群需要大量的周边基础设施才能正常运行。

我们漏掉了一个很酷的东西,那是一个特殊的“工具”,可以帮助在架空线槽中布线。

我们参观这个集群时,它拥有数千个 GPU,而且 Lambda 正在积极扩展集群。在此之前,我们关于 AI 集群中被遗忘的部分的部分,不仅是为了展示支持 AI 集群的传统 CPU 计算服务器等方面,也是为了突出 AI 构建的快速发展以及所有需要顺利进行的事情,以便 GPU 像下面的机器一样,尽可能少地运行。这台 GPU 系统已安装到机架上,但尚未通电。这意味着它不属于训练或推理集群,也不会产生收入。

当我看到正在进行的人工智能集群时,我经常会看到像上面的服务器这样的景象,并想到停在机场而不是天空中赚取收入的飞机。

我在本文前面提到,在视频中,我们派了第二个团队去占领另一个地点。Lambda 不仅围绕更传统的 NVIDIA HGX B200 8-GPU 平台进行构建,还围绕较新的 NVIDIA GB200 NVL72 液冷机架进行构建。

NVL72 机架通过 NVIDIA NVLink 连接,提供了更大的纵向扩展域。十多年来,我们一直在 ServeTheHome 上评测传统的 8 GPU 服务器,但这些服务器一直用于横向扩展集群连接。相比之下,NVL72 机架的设计旨在将加速器紧密集成在一起,并实现高速互连。

对于像 Lambda 这样的新云提供商来说,能够提供两种类型的计算并以无摩擦的方式为客户提供它们,是与为传统计算应用程序构建的传统超大规模云相比的关键区别之一。

最后的话

在本文中,我们涵盖了丰富的内容。我们从在 Cologix 的大厅中展示的 10U Supermicro NVIDIA HGX B200 平台,到运行着数千个 GPU 的 AI 集群,以及从冷箱到token生成基础设施所需的所有支持组件。

展示一个风冷设施也很棒。实际上,即使是这种规模的AI集群,可能最多还需要12到18个月才能几乎全部部署液冷。

虽然我之前参观过更大规模的集群,并且在STH上展示过一些,但能够展示这些集群不仅仅是一堆GPU AI服务器,还是非常令人欣喜的。这些GPU服务器是为多个客户运行工作负载而存在的,因此需要配套的基础设施。

GPU 计算固然很酷,但我更感兴趣的是这些大型 AI 集群的网络部分。我们的服务器配备了 8 个 GPU、2 个 CPU,但每个节点却有十几个网络连接。

可以肯定的是,与当今的人工智能集群建设相比,即使是这种规模的集群,你也会开始感到自己非常渺小。

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

END

今天是《半导体行业观察》为您分享的第4126期内容,欢迎关注。

加星标⭐️第一时间看推送,小号防走丢

求分享

求推荐

探秘NVIDIA HGX B200集群,超多图:深度解析NVIDIA最新超级计算平台相关教程

- 微软专家揭秘Gmail AI诈骗事件:全程“超级逼真”险象环生

- 微软和OpenAI计划斥资1000亿美元开发超级计算机Stargate,领先科技创新引领未来发展

- 中国超越美国,国产CPU荣登全球第一,成为超算芯片新宠

- AMD锐龙9000台式机处理器:超强“有效频率”表现揭秘

- AMD 锐龙8000F系列处理器正式登场,搭建高性能超值AM5平台

- DIY从入门到放弃:CPU主频/倍频/睿频/超频别迷糊,全面解析!

- 微软携OpenAI欲斥资千亿美元建造AI超算,AI芯片需求的“狂飙之路”揭开神秘面纱

- 世界品牌500强揭秘:华为不如腾讯,微软反超苹果成第一,特斯拉超奔驰

- win11升级正在撤销对计算机所做的更改 如何解决Win11撤销对计算机所做的更改问题

- 德国超算系统Hunter和Herder获得新订单,AMD Instinct MI300A引领前沿科技

- Win10/Win11官方优化工具PowerToys 0.93发布:全新功能和改进一览

- 微软发布Win11 24H2 RP 26100.5061预览版,全新系统功能抢先体验

- Windows最新补丁导致事件查看器出现虚假错误警报解决方法

- “骇客”再现,华硕ROG预热新款Matrix显卡震撼发布

- 微软:争夺Meta AI人才,最高薪酬方案超400万美元,如何吸引顶尖人才?

- 历史重演!Windows事件查看器再弹错误 微软:不用管,如何解决?

热门推荐

微软资讯推荐

- 1 Win10/Win11官方优化工具PowerToys 0.93发布:全新功能和改进一览

- 2 微软发布Win11 24H2 RP 26100.5061预览版,全新系统功能抢先体验

- 3 “骇客”再现,华硕ROG预热新款Matrix显卡震撼发布

- 4 微软Win11推送8月累积更新:快速机器恢复功能上线,让您的设备更加高效!

- 5 微软即将终止对 Windows 11 版本 23H2 的支持,影响及时更新和安全防护

- 6 微软17亿美元收购490万吨美国人屎,背后有什么秘密?

- 7 英伟达H20芯片出口对华:中美技术博弈进入哑谜阶段

- 8 男子法院起诉微软:强迫用户升级Win11、停服Windows 10,背后原因令人震惊

- 9 Intel推出新款ARC B系列显卡,非高端产品ARC B380现身

- 10 AMD 2025Q2财报:季度收入创新高,同比增长32%,达76.85亿美元

win10系统推荐

系统教程推荐

- 1 win11键盘突然变成快捷键 win11键盘快捷键取消方法

- 2 windows10复制文件需要管理员权限 如何解决需要管理员权限才能复制文件夹的问题

- 3 右键新建没有ppt怎么办 Win10右键新建菜单中没有PPT如何添加

- 4 打开电脑触摸板 win10触摸板功能开启

- 5 多个word在一个窗口打开 Word如何实现多个文件在一个窗口中显示

- 6 浏览器分辨率怎么调整 浏览器如何设置屏幕分辨率

- 7 笔记本电脑开不了机怎么强制开机 笔记本电脑按什么键强制开机

- 8 怎样看是不是独立显卡 独立显卡型号怎么查看

- 9 win11电脑唤醒不了 Win11睡眠无法唤醒怎么解决

- 10 无线网络密码怎么改密码修改 无线网络密码如何更改