人工智能,需要怎样的DRAM?最全面的人工智能DRAM选择指南

公众号记得加星标⭐️,第一时间看推送不会错过。

来源:内容编译自semiengineering。

人工智能 (AI) 涉及高强度计算和海量数据。计算可以由 CPU、GPU 或专用加速器执行,而数据在传输到处理器的过程中会经过 DRAM,因此,最适合此用途的 DRAM 类型取决于执行训练或推理的系统类型。

如今,工程团队面临的内存挑战是如何满足人工智能快速增长的计算需求,而同步 DRAM 在其中发挥着至关重要的作用。所有这些数据都需要处理、存储和访问,这些步骤中的任何不匹配都可能影响整体系统性能。

Cadence产品营销部总监 Frank Ferro 表示:“我们获得了所有这些计算能力。但从内存带宽的角度来看,如何利用它呢?”

没有简单的答案,也没有一刀切的解决方案。目前,同步 DRAM (SDRAM) 分为四类,每类都有各自的目标用途和优缺点:

1、双倍数据速率(DDR )内存通常与 CPU(尤其是复杂指令集架构 (CISC) 处理器)搭配使用。程序可能包含复杂的分支和各种各样的操作,而 DDR 针对此类计算进行了优化。DDR 是最通用的架构,具有最快的延迟(第一个数据的时间),并且由于采用 64 位数据总线而具有适中的带宽。“双倍数据速率”指的是数据在时钟的上升沿和下降沿同时进出内存。这与之前的内存和大多数逻辑电路不同,它们仅在一个边沿进行时钟控制。

2、低功耗 DDR ( LPDDR )与 DDR 类似,但它包含许多在后续版本中逐步添加的功能,以便在保持高性能的同时降低功耗。其节能特性包括:

降低电源电压;

温度补偿刷新率,允许在寒冷时减少刷新频率;

深度和部分断电模式;

部分阵列刷新选项;

写入均衡,补偿数据选通和时钟信号之间的偏差;

命令/地址训练以优化信号时序和完整性;

更低的I/O电容;

后续几代采用 6 位单数据速率 (SDR) 命令和地址总线,而不是之前的 10 位 DDR 总线;

两条半宽总线,而不是一条全宽总线;

差分时钟;

数据复制和 Write-X(写入全部 1 或全部 0)命令,以减少这些用例的数据传输;

差分电压和频率调节 (DVFS)。

后续几代产品包含更复杂的时钟结构,其中有一个四分之一速度的主时钟持续运行,从中衍生出多个仅在必要时运行的全速时钟。

LPDDR 并非内置于双列直插式内存模块 (DIMM) 中,而是采用 BGA 封装,直接焊接到电路板上。

图形 DDR (GDDR(Double Memory,即GDDR )是一种配合GPU进行图形处理的变体。它拥有比DDR更高的带宽,可以向处理器传输大量图形数据,但延迟也比DDR更高。“GDDR的带宽要好得多,但容量是个问题,”Ferro说道。

高带宽内存( HBM )涉及具有非常宽总线的 DRAM 芯片堆栈,可以提供必要的非常高的带宽。以防止内存访问成为数据密集型计算(例如 AI 训练、AI 推理和高性能计算 (HPC))的瓶颈。

这四种 DRAM 类型的主要区别在于访问协议,而不是存储单元。“无论你使用的是 GDDR、LPDDR、DDR 还是 HBM,底层的内存技术基本上都是相同的,”Ferro 指出。“你仍然拥有基本的 DRAM 技术。关键在于你如何访问 DRAM。”

这些不同的访问方式会对性能和功耗产生很大的影响。

图 1:不同 SDRAM 系列的比较。容量以单芯片计算(HBM 不以单堆栈计算)。没有哪个系列在各方面都表现出色。DDR 和 LPDDR 的吞吐量和容量可以相媲美,但成本是主要区别

数据中心之王

数据中心是 HBM 无可争议的领地。Expedera 首席软件工程师 Ramteja Tadishetti 表示:“我们认为 HBM 仍将主要应用于数据中心的训练和超高速接口。但HBM 的价格可能会使其局限于云端,远离注重成本的边缘设备。”

HBM 能耗更高,价格也更高,但数据中心的其他设备也一样。Quadric 首席营销官 Steve Roddy 表示:“虽然 HBM 是本地内存中最昂贵、最耗电的选择,但与训练芯片中使用的全光罩尺寸裸片的成本和功耗相比。它的成本和功耗只是九牛一毛。 ”用房地产来打个比方,如果你在比佛利山庄花2500万美元买了一块地,你就不会为了省钱而建造这栋房子。数据中心也是如此。一旦你选择了昂贵的芯片和封装,HBM的增量就变得无关紧要了。

由此推论,我们还没有看到HBM在数据中心之外的任何应用计划——即使是高端汽车市场也没有。打造高端SAE Level 4自动驾驶辅助系统(ADAS)的汽车公司需要采用风冷且成本低于四位数的硅片解决方案。他们无法容纳成本高达1万美元或更高的1000瓦模块。

这些成本考量将迫使那些无力承担HBM成本的厂商做出妥协。“超大规模厂商通常拥有足够的资金和资源来支持HBM,”新思科技内存接口产品线总监Brett Murdock解释道。“二线厂商必须开始做出权衡,因为他们的产量不足以吸引HBM供应商或2.5D组装商的关注,从而无法支持HBM解决方案。”

HBM 对于训练尤为重要,因为训练需要的带宽比推理更高。它仍然用于数据中心推理,但 LPDDR 和 GDDR 也正在获得越来越多的关注。“HBM 已成为近内存使用的一种流行选择,可用于训练这些模型,”Ferro 说。“我猜测 GDDR 和 LPDDR 将成为推理加速器卡上的主流内存。”

Murdock 对此表示赞同,并指出两者之间应该采取更多混合方案。“训练比推理需要更多内存,所以人们可能更倾向于 HBM4 和 LPDDR6 的组合,其中 LPDDR6 是为了满足容量需求——除非你已经因为其他原因从 HBM4 降级到 LPDDR6。”

三星也见证了类似的趋势。“我们看到越来越多的混合内存,”三星 IP 和生态系统营销高级总监 Kevin Yee 表示。“不仅仅是 DDR、LPDDR、GDDR 或 HBM。我们开始看到为了节省功耗而混合使用,比如 DDR 和 LPDDR,或者 HBM 和 LPDDR。”

一个新兴的切入点是定制HBM,大批量采购商可以与内存制造商合作,将堆栈底部的标准逻辑基础芯片替换为具有专有增值功能甚至优化通道的定制芯片。Yee指出:“采用定制HBM,可以使用某种专有的芯片间协议,这将带来更好的带宽和更高的传输效率。”

虽然所有存储器都需要考虑散热问题,但对于HBM来说尤其如此,因为它是一个堆叠结构,而任何堆叠结构都会带来散热挑战,尤其是堆叠中间的芯片。多物理场仿真是必要的,但这需要更精确的模型。“表征这种三维堆叠结构的热行为面临诸多挑战,”弗劳恩霍夫IIS自适应系统工程部设计方法部门负责人Roland Jancke说道。“对于存储器堆叠来说,这显然是事实,但如果堆叠结构包含处理器、存储器、传感器或其他组件,则同样如此。”

最后,还有地缘政治因素。“除了可用性和成本之外,另一个考虑因素是政治因素。如果用非常宽泛的眼光来看,HBM 基本上对中国来说是禁区,”Murdock 指出。“因此,中国公司目前在 AI 设计中使用 LPDDR5X,而未来则将转向 LPDDR6。”

CPU 的固定伴侣

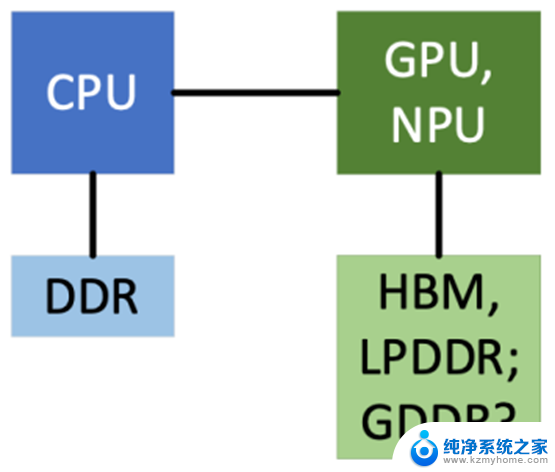

DDR 在数据中心中发挥着作用,但它通常服务于协调操作的 CPU。加速器,无论是 GPU 还是神经处理单元 (NPU),通常都依赖于数据中心的 HBM 和/或 LPDDR 来实现更高的带宽或更低的功耗。

图 2:CPU 与 G/NPU 所采用的内存对比。DDR 擅长执行 CPU 通常执行的通用顺序计算,而 HBM 和 LPDDR 则为涉及高度并行性的训练和推理算法所需的海量数据提供了更高的带宽或更低的功耗。GDDR 也可能出现在那里

Murdock 表示:“通常情况下,服务器和 DDR 是密不可分的。如今,DDR5 RDIMM 是黄金标准,但有些服务器正在转向 DDR5 MRDIMM(多路复用 RDIMM,通过对两个 RDIMM 进行乒乓操作使带宽翻倍),因为它们可以利用现有的 DRAM 提供更高的性能。DDR5 MRDIMM 在价格和功耗方面都比较昂贵。”

但 DDR 并未针对处理 AI 数据模式进行优化。Expedera 的 Tadishetti 表示:“DDR 仍然是一种可靠的二级存储方法。然而,除非延迟和性能有显著改善,否则它在效率方面无法与 LPPDR 竞争,在原始性能方面也无法与 GDDR/HBM 竞争。”

话虽如此,它无处不在,而且价格低廉。“对于不受功耗限制的大规模推理优化设备,DDR 是首选的本地内存,”Roddy 说道。“对于任何线路供电(家庭、办公室、工厂)或自带电源(汽车)的设备,DDR 的速度和成本组合都是不败的王者。在智能管理外部内存的 NPU 子系统上运行的推理应用程序能够批量处理和预取 DDR 访问,从而最大限度地提高性能,同时充分利用 DDR 可用性带来的巨大规模经济效益。”

舞会上的新花魁

不过,LPDDR 已开始渗透到各种系统中,如果它不能取代其他替代品,它可能会被添加到系统中以降低功耗。

Roddy 表示:“对于电池和功耗受限的设备,LPDDR 提供了卓越的带宽与功耗平衡。手机市场对 LPDDR 的大量生产,使其成为大多数以 AI 为中心的新兴消费电子和便携式设备的成本敏感型选择。”

其他人也同意这一点。“LPDDR 是内存领域的万能者——事实上,它在某些方面堪称大师,”Murdock 说。“它同时占领了移动和汽车应用领域。”

人们甚至可以尝试用它来创建一个穷人版的HBM。“你可以堆叠LPDDR来获得容量,” Rambus内存接口芯片产品营销副总裁John Eble指出。

LPDDR 也正在进入数据中心,作为一种降低功耗的方式,尽管它无法满足超大规模数据中心用户的所有需求。“LPDDR 的主要缺点是缺乏 RAS(可靠性、可用性、可维护性)功能,而且它不具备同等程度的 ECC,”Eble 说道。“或者说,存在‘芯片失效’的概念,即 DRAM 芯片失效后可以恢复。LPDDR 的设计初衷并非为了实现这种级别的 RAS 功能。”

尽管 DDR 通常与 CPU 配套使用,但 LPDDR 也已占据先机。“NVIDIA 推出了基于 Arm 的 Grace 处理器,并选择将其与 LPDDR 内存捆绑,”Eble 补充道。

在性能至关重要的边缘系统中,LPDDR 也可能取代 DDR。“许多边缘设备没有内存,而那些有内存的设备通常只需要很少的内存,所以它们倾向于寻找最便宜的内存,”Murdock 说。“那些真正需要内存发挥一定性能的设备会选择 LPDDR,因为它的功耗和性能都很好。”

总是被人嫌弃?

在 AI 系统中,GDDR 是比较少见的内存家族,它具备一些对 AI 系统有吸引力的特性,但在关键参数上往往屈居第二。GDDR 的吞吐量高于 LPDDR,但低于 HBM。它的成本低于 HBM 或 LPDDR,但不低于 DDR。目前还没有明确的参数要求某些类型的系统必须使用 GDDR。因此,GDDR 经常被 AI 系统所忽略。

Roddy 表示:“GDDR 似乎是 AI 应用的反“金发姑娘”方案。它总是‘不合适’。对于面向推理的消费设备来说,GDDR 价格过高,而设计精良、具有离线编译功能的 NPU 可以智能地预取权重和激活函数,这样就永远不需要 GDDR 更快的随机访问速度了。而在数据中心,HBM 的原始速度优势已经取代了 GDDR。”

然而,只要其有限的容量不成为障碍,它对于图形相关的生成算法来说前景光明。“它主要用于图形和生成式人工智能的某些方面,”Tadishetti 说。“随着我们观察到图像和视频生成模型的日益增长趋势,一些需求可能会转向 GDDR——但需要明确的是,我们还没有看到 OEM 这样做。”

四大路线图

所有 DRAM 标准均源自 JEDEC,但每种类型都有各自的委员会。DDR 由 JC-42.3 子委员会(典型的 JEDEC 命名法,其中 JC-42 涵盖所有固态存储器)负责,JC-42.1 负责标准化 GDDR,JC-42.2 负责 HBM,JC-42.6 负责 LPDDR。这四个委员会都在继续推进各自的 DRAM 产品,但 LPDDR 和 HBM 版本正受到更多关注。

Murdock 表示:“LPDDR5X 现已上市,价格合理,能够满足许多应用的功耗和性能需求。鉴于 LPDDR6 相较于 LPDDR5X 的性能提升,我们已经看到设计初期对它的需求。”

虽然 LPDDR6 的具体变化尚未公开,但预计主要会影响时钟速度、存储方式、总线宽度和突发访问。此外,它还内置了纠错码 (ECC),这证明了高速下单元和信号的脆弱性。预计该芯片将于今年年底上市。

HBM4 是备受期待的下一代高带宽内存版本。与 HBM3 相比,它的带宽、通道数和数据总线宽度均翻了一番。预计将于 2026 年上市。“HBM3E 目前已可轻松获得,但 HBM4 JEDEC 标准刚刚发布,因此设计工作将迅速转向 HBM4,以获得其带来的更高性能,”Murdock 说道。

动态环境

即使内存速度提升、相对功耗下降,处理器也在经历类似的发展。理想情况下,处理器和内存应该同步发展,不会成为瓶颈。但它们是独立开发的,因此未来总会有一些跨越式发展。

尽管专用NPU难以大规模应用,但其中一些NPU承诺实现低功耗执行。如果它们流行起来,将给功耗受限系统中使用的内存带来更大压力。同样,随着数据中心处理器性能的提升,HBM也需要跟上步伐。

仅仅选择合适的内存是不够的。确保高质量的访问信号对于高速运行至关重要。“从系统性能的角度来看,这些通道确实是最重要的,我们必须考虑信号完整性,”Cadence 的 Ferro 说道。“如果我是一名系统设计师,我应该能够从一家供应商那里购买 GDDR6 DRAM,然后从另一家供应商那里安装 GDDR6。但是,一家供应商的 GDDR6 DRAM 的运行速度可能为 16 GB/s,而另一家供应商的 DRAM 可能有 18 GB/s 的版本。你可以把那一家供应商的 GDDR6 DRAM 放进去,它也能工作,但那个通道能处理 18 GB/s 的速度吗?”

尽管趋势很明显,但系统设计师仍然需要做好功课,为特定系统找到最合适的特定内存,并确保系统能够跟上。

参考链接

https://semiengineering.com/the-best-drams-for-ai/

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

END

今天是《半导体行业观察》为您分享的第4064期内容,欢迎关注。

加星标⭐️第一时间看推送,小号防走丢

求分享

求推荐

人工智能,需要怎样的DRAM?最全面的人工智能DRAM选择指南相关教程

- 微软通用人工智能研究副总裁离职加入OpenAI,开启新的人工智能之路

- 微软支持的OpenAI发布GPT-4 Turbo:让您定制ChatGPT的最强人工智能

- 微软首席执行官Satya Nadella年度信中的9大人工智能计划

- 微软最新人工智能技术:静态图像变身逼真动画

- 微软计划发布以人工智能为中心的新一代Windows版本,引领智能化操作系统发展

- OpenAI与微软的危机:人工智能一旦失败,或将毫无用处

- 万亿芯片巨头英伟达:人工智能算力浪潮下,中国市场的重要性不可忽视

- 微软与美国劳工联合会 AFL-CIO 达成中立协议,共同探索人工智能的未来

- 如何选择最适合自己的显卡?显卡选择指南全解析!

- 如何维护Windows工具?最全面的维护指南

- 英伟达股价四连跌失守关键技术位,分析师警示短期动能转弱风险

- 那些逆风翻盘的品牌:超威AMD篇,探索其成功之路

- GPU、CUDA之外,NVIDIA还有Jetson Thor,剑指机器人市场的最新产品信息

- 对于大多数人来说,显卡真的性能过剩了吗?如何选择适合自己的显卡性能?

- NVIDIA发布全球首个 DRIVE AGX Thor 开发者套件,抢先体验汽车领域革新技术

- 明年6月后,部分老旧英伟达显卡或无法正常启动,如何解决?

热门推荐

微软资讯推荐

- 1 那些逆风翻盘的品牌:超威AMD篇,探索其成功之路

- 2 GPU、CUDA之外,NVIDIA还有Jetson Thor,剑指机器人市场的最新产品信息

- 3 对于大多数人来说,显卡真的性能过剩了吗?如何选择适合自己的显卡性能?

- 4 NVIDIA发布全球首个 DRIVE AGX Thor 开发者套件,抢先体验汽车领域革新技术

- 5 Win11无限转圈?教你解决Win11欢迎界面问题!如何应对Win11欢迎界面无限加载的困扰?

- 6 NVIDIA新加坡营收达100亿美元!仅次于美国居第二,亚洲第一的科技巨头

- 7 AMD原装处理器散热器“幽灵”螺旋与棱镜进入停产阶段,如何选择替代产品?

- 8 NVIDIA全栈技术加速枢途科技构建具身训练数据新范式:领先AI训练技术带来数据处理革新

- 9 服务器CPU,变局已至!—如何选择适合自己的服务器CPU?

- 10 微软Win11更新:修复多个bug,新增新功能最新消息

win10系统推荐

系统教程推荐

- 1 win11键盘突然变成快捷键 win11键盘快捷键取消方法

- 2 windows10复制文件需要管理员权限 如何解决需要管理员权限才能复制文件夹的问题

- 3 右键新建没有ppt怎么办 Win10右键新建菜单中没有PPT如何添加

- 4 打开电脑触摸板 win10触摸板功能开启

- 5 多个word在一个窗口打开 Word如何实现多个文件在一个窗口中显示

- 6 浏览器分辨率怎么调整 浏览器如何设置屏幕分辨率

- 7 笔记本电脑开不了机怎么强制开机 笔记本电脑按什么键强制开机

- 8 怎样看是不是独立显卡 独立显卡型号怎么查看

- 9 win11电脑唤醒不了 Win11睡眠无法唤醒怎么解决

- 10 无线网络密码怎么改密码修改 无线网络密码如何更改